www.industrieweb.fr

28

'25

Written on Modified on

Une navigation intelligente, une inspection sûre

Inspection des infrastructures critiques à l'aide de drones intelligents équipés de caméras IDS USB3 Vision de la famille uEye LE.

en.ids-imaging.com

L'inspection des infrastructures critiques telles que les installations énergétiques, les ponts ou les complexes industriels est essentielle pour garantir leur sécurité, leur fiabilité et leur fonctionnalité à long terme. Les méthodes d'inspection traditionnelles nécessitent toujours l'intervention de personnes dans des zones difficiles d'accès ou à risque. Les robots mobiles autonomes offrent ici un grand potentiel pour rendre les inspections plus efficaces, plus sûres et plus précises. Les Uncrewed Aerial Vehicles (UAV) sous forme de drones se sont notamment imposés comme des plateformes prometteuses en raison de leur flexibilité d'utilisation et de leur capacité à atteindre par les airs même les zones difficiles d'accès. L'un des plus grands défis est de faire naviguer le drone avec précision par rapport aux objets à inspecter, afin de capturer de manière fiable des données d'images haute résolution, des valeurs de mesure ou d'autres données capteurs. Un groupe de recherche de l'université de Klagenfurt a conçu à cet effet un drone capable de fonctionner en temps réel, basé sur une navigation relative à l'objet à l'aide d'une intelligence artificielle. À bord : une caméra industrielle USB3 Vision de la famille uEye LE de IDS Imaging Development Systems GmbH.

Dans le cadre de ce projet de recherche, financé par le ministère fédéral autrichien de la protection du climat, de l'environnement, de l'énergie, de la mobilité, de l'innovation et de la technologie (BMK), le drone doit distinguer de lui-même un poteau électrique d’un isolateur. Elle doit voler à une distance de trois mètres autour de l'isolateur et prendre des photos. "La localisation précise est importante pour que les enregistrements issus des caméras soient également comparables", explique Thomas Georg Jantos, doctorant et membre du groupe de recherche Control of Networked Systems de l'université de Klagenfurt. Condition préalable : la navigation relative à l'objet doit être en mesure d'extraire des informations dites sémantiques sur les objets concernés à partir des données sensorielles brutes saisies par la caméra. Les informations sémantiques rendent les données brutes, ici les images issues de la caméra, "compréhensibles" et permettent non seulement de saisir l'environnement, mais aussi d'identifier et de localiser correctement les objets pertinents.

Dans ce cas, cela signifie par exemple qu'un pixel n'est pas seulement considéré comme une valeur couleur indépendante (par exemple une valeur RGB), mais comme une partie d'un objet, par exemple un isolateur. Contrairement au GNNS (Global Navigation Satellite System) classique, cette approche ne fournit pas seulement une position dans l'espace, mais aussi une position et une orientation relatives précises, respectivement de l'objet à inspecter (par ex. "Le drone se trouve à 1,5 m à gauche de l'isolateur supérieur").

La principale exigence est que le traitement des images et l'interprétation des données doivent se faire sans latence, afin que le drone puisse adapter sa navigation et son interaction en temps réel aux conditions et exigences spécifiques de la tâche d'inspection.

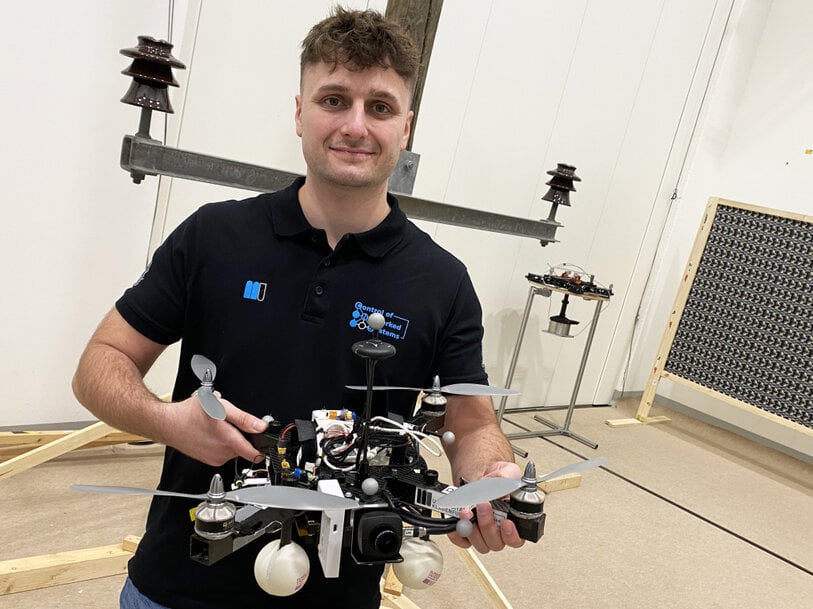

Thomas Jantos avec le drone d'inspection - Photo : aau/Müller

Informations sémantiques grâce au traitement intelligent des images

La reconnaissance des objets, la classification des objets et l'estimation de leur position sont effectuées à l'aide de l'intelligence artificielle lors du traitement des images. "Contrairement aux approches d'inspection par drone basées sur le GNSS, notre IA permet, grâce à ses informations sémantiques, d'inspecter l'infrastructure à inspecter sous certains angles reproductibles", concrétise Thomas Jantos. "De plus, l'approche choisie ne souffre pas des problèmes habituels du GNSS, tels que le multi-pathing et l'occultation, qui sont causés par les grandes infrastructures ou les vallées et peuvent entraîner une dégradation du signal et donc des risques pour la sécurité".

Une USB3 uEye LE sert de caméra de navigation au quadricoptère

Combien d'IA peut contenir un petit quadricoptère ?

La configuration matérielle consiste en une plateforme TWINs Science Copter équipée d'un pilote automatique Pixhawk PX4, d'un DevKit NVIDIA Jetson Orin AGX 64GB comme ordinateur de bord et d'une caméra industrielle USB3 Vision d'IDS. "Le défi est de faire en sorte que l'intelligence artificielle s'adapte aux petits hélicoptères. Les ordinateurs sur le drone sont encore trop lents par rapport aux ordinateurs avec lesquels l'IA est entraînée. Avec les premiers tests réussis, cela continue à faire l'objet de recherches actuelles", explique Thomas Jantos pour décrire la problématique consistant à optimiser davantage le modèle d'IA performant pour une utilisation sur l'ordinateur de bord.

En revanche, la caméra fournit d'emblée des données de base parfaites, comme le montrent les tests effectués dans le hall des drones de l'université. Lors de la sélection du modèle de caméra approprié, il ne s'agissait pas seulement de répondre aux exigences en matière de vitesse, de taille, de classe de protection et enfin de prix. "Les capacités de la caméra sont essentielles pour le nouvel algorithme de navigation basé sur l'IA du système d'inspection", explique Thomas Jantos. Il a choisi le modèle U3-3276LE C-HQ, une caméra peu encombrante et peu coûteuse de la famille uEye LE. Le capteur intégré Sony Pregius IMX265 est probablement le meilleur capteur d'image CMOS dans la catégorie 3 MP et permet une résolution de 3,19 mégapixels (2064 x 1544 px) avec une fréquence d’image allant jusqu'à 58,0 ips. L'obturateur global shutter 1/1.8" intégré, qui ne produit pas d'images 'déformées' pour ces temps d'exposition courts par rapport à un obturateur rolling shutter, joue un rôle déterminant dans la performance du capteur.

"Pour garantir un vol d'inspection sûr et robuste, une qualité d'image et une fréquence d’image élevés sont indispensables", concrétise Thomas Jantos. En tant que caméra de navigation, l'uEye LE fournit ainsi à l'IA embarquée les images complètes dont l'ordinateur de bord a besoin pour calculer la position relative et l'emplacement de l'objet à inspecter. Sur la base de ces informations, le drone est en mesure de corriger sa pose en temps réel.

La caméra IDS est reliée à l'ordinateur de bord par une interface USB3. "Grâce à l'IDS peak SDK, nous pouvons intégrer très facilement la caméra et ses fonctionnalités dans le ROS (Robot Operating System) et donc dans notre drone", explique Thomas Jantos. En outre, IDS peak permet un traitement efficace des images brutes et un ajustement facile et automatique des paramètres de prise de vue tels que l'exposition, la balance des blancs, le gain et le sous-échantillonnage.

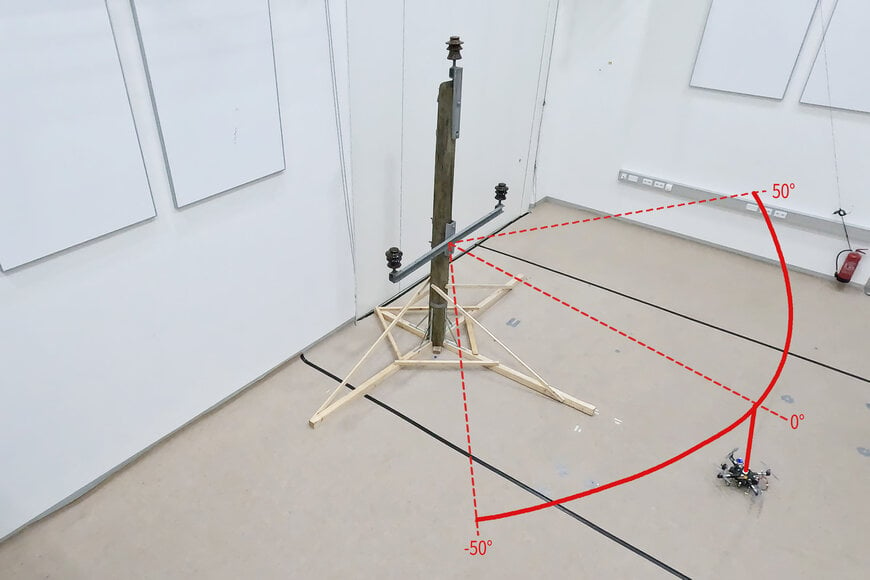

Afin de garantir un haut niveau d'autonomie, de contrôle, de gestion de mission, de surveillance de la sécurité et d'enregistrement des données, les chercheurs utilisent la CNS Flight Stack dont les sources sont disponibles sur l'ordinateur de bord. La CNS Flight Stack comprend des modules logiciels pour la navigation, la fusion de capteurs et les algorithmes de contrôle, et permet d'effectuer des missions autonomes reproductibles et adaptables. "La modularité de la CNS Flight Stack et les interfaces ROS nous permettent d'intégrer de manière transparente nos capteurs ainsi que l''estimateur d'état' basé sur l'IA pour la détection de position dans l'ensemble de la pile et de réaliser ainsi des vols de drones autonomes. Nous étudions et développons la fonctionnalité de notre approche en prenant pour exemple un vol d'inspection autour d'un pylône électrique dans le hall des drones de l'université de Klagenfurt", explique Thomas Jantos.

√ Informations sur CNS Flight Stack

√ Informations sur le hall des drones

Visualisation de la trajectoire d'un vol d'inspection autour d'un modèle de pylône électrique avec trois isolateurs dans le laboratoire de recherche de l'université de Klagenfurt

Alignement précis et autonome grâce à la fusion des capteurs

Les signaux de contrôle à haute fréquence pour le drone sont générés par l'IMU (Inertial Measurement Unit). La fusion des capteurs avec les données de la caméra, le LIDAR ou le GNSS (système global de navigation par satellite) permet la navigation et la stabilisation du drone en temps réel - par exemple pour les corrections de position ou l'alignement précis sur les objets à inspecter. Dans le drone de Klagenfurt, l'IMU du PX4 est utilisé comme modèle dynamique dans un EKF (filtre de Kalman étendu). L'EKF estime, en se basant sur la dernière position connue, la vitesse et l'emplacement où le drone devrait se trouver maintenant. Ensuite, de nouvelles données (provenant par exemple de l'IMU, du GNSS ou de la caméra) sont acquises à une fréquence pouvant atteindre 200 Hz.

Pour ce faire, la caméra enregistre des images brutes à 50 ips dans une taille d'image de 1280 x 960px. "C'est le taux de fréquence d'image maximal que nous obtenons avec notre modèle d'IA sur l'ordinateur embarqué du drone", explique Thomas Jantos. Au démarrage de l'appareil photo, une balance des blancs automatique et un ajustement du gain sont effectués une seule fois, tandis que le contrôle automatique de l'exposition reste désactivé. L'EKF compare la prévision et la mesure et corrige l'estimation en conséquence. Ainsi, le drone reste stable et peut maintenir sa position de manière autonome et très précise.

Un pylône électrique avec isolateurs dans le hall des drones de l'université de Klagenfurt sert aux vols d'essai

Perspectives

"En ce qui concerne la recherche dans le domaine des robots mobiles, les caméras industrielles sont nécessaires pour un grand nombre d'applications et d'algorithmes. Dans ce contexte, il est important que ces caméras soient robustes, compactes, légères, rapides et à haute résolution. Le prétraitement embarqué (par exemple le binning) est également d'une grande importance, car il permet d'économiser un temps de calcul et des ressources précieuses sur le robot mobile", souligne Thomas Jantos. Grâce à leurs caractéristiques, les caméras IDS contribuent à établir un nouveau standard dans l'inspection autonome d'infrastructures critiques dans le cadre de cette approche de recherche prometteuse, qui augmente de manière significative la sécurité, l'efficacité et la qualité des données.

Caméra

uEye LE

La caméra de projet à prix avantageux et peu encombrante

Modèle utilize :

USB3 Vision Industriekamera U3-3276LE Rev.1.2

Famile de cameras : uEye LE

www.ids-imaging.fr

This email address is being protected from spambots. You need JavaScript enabled to view it.